论文FasDL:An Efficient Serverless-Based Training Architecture with Communication Optimization and Resource Configuration被IEEE Transactions on Computers(CCF A)期刊接收,恭喜星耒!

论文主题内容介绍

研究背景

无服务器计算已经引起了深度学习从业者的关注。例如,LambdaML为无服务器深度模型训练提供了全面的特性描述。然而,在实践应用中,仍然存在以下问题。一方面,由于无服务器计算的无状态性质,导致了点对点通信的缺失。这种缺失阻止了传统通信模式(如Ring AllReduce和Decentralized Parallel)的实现,因为这些模式依赖于工作节点之间的稳定连接。尽管LambdaML实现了两种通信模式——AllReduce和ScatterReduce,并使用外部存储作为通信通道,但通信开销依然可能高达计算延迟的6倍。另一方面,虽然无服务器计算可以减轻运维负担,但深度学习从业者仍需要配置系统级和应用级参数,以平衡训练延迟、模型准确性和经济成本。参数配置的误差可能导致训练速度下降或成本上升。

解决方案

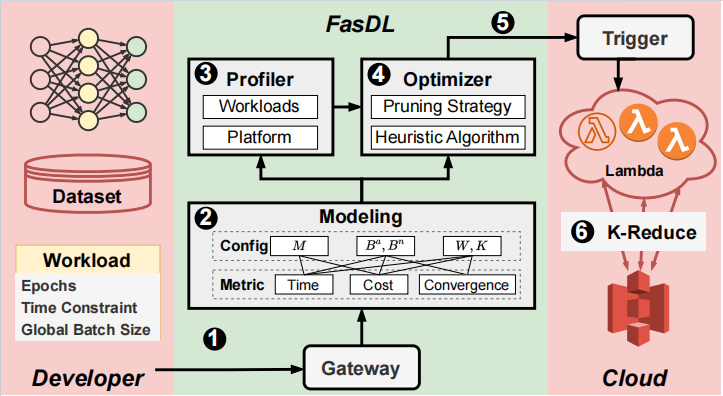

(1)设计了一个新的训练框架,K-REDUCE,以增强基于无服务器计算的模型训练性能。采用了一种新颖的通信模式来减少过度的通信开销,并同时设计了一个适合的数据划分方案和同步协议,以进一步加速训练过程。

(2)构建数学模型描述系统级和应用级参数与训练延迟、模型准确性和经济成本之间的关系,以解决在无服务器计算环境中进行深度学习训练时的参数配置挑战。此外,采用了一种基于剪枝的启发式搜索算法,以高效地寻找最优的参数配置,进一步提升了训练效率和经济效益。

设计概述

(1)K-REDUCE训练框架是FasDL的核心组成部分,它通过选择最优的聚合器数量K来减少通信时间,并通过不等量的数据集划分方案以及混合异步并行协议来加速训练。这是FasDL的一个创新点,因为传统的训练框架通常无法动态地调整参数配置以适应不同的训练任务和系统环境。

首先,通过最优K-聚合器选择以优化通信。K-REDUCE框架选择最优的K个工作节点(1≤K≤W)作为聚合器,其余的W-K个工作节点作为非聚合器,以最小化通信开销。我们建立了一个模型来描述通信开销与聚合器数量之间的关系,并设计了一种启发式算法来有效地搜索最优的聚合器数量K。

接着,提出加强数据分区和同步以加速训练。我们利用非聚合器的空闲时间来加速训练过程。为此,我们设计了一种不等量数据集划分方案和一种混合异步并行协议。不等量数据集划分方案精确地将额外的数据分配给非聚合器,而混合异步并行协议则针对工作节点的不同角色灵活地实现了不同的同步协议。我们设计了一种不等量的数据集划分方案,该方案将额外的训练样本精确地分配给非聚合器。

(2)首先构建了一个数学模型,该模型描述了系统级和应用级参数与训练延迟、模型准确性和经济成本之间的关系。然后,通过收集实验数据来确定模型的系数。这些系数可以帮助FasDL预测未见过的参数配置的性能,并理解各个参数对性能的影响。具体的,该模型描述了无服务器分布式训练的双层参数(包括内存配额M、工作节点总数W和批量大小B)以及由K-REDUCE引入的系统级参数(聚合器数量K)与训练延迟、经济成本和收敛效率之间的关系。

在建模的基础上,使用基于剪枝的启发式搜索算法来寻找最优的参数配置。这个算法首先使用模型预测所有可能的参数配置的性能,然后剪枝掉预计性能较差的配置,缩小搜索空间。这个过程会反复进行,直到找到最优的配置。

实验结果

在AWS Lambda平台上进行的大量实验表明,该系统在预测准确率方面超过了94%。这些实验不仅验证了系统的高预测准确性,还展示了其在性能和成本方面相对于当前最先进的架构LambdaML的显著优势。具体来说,在性能方面,该系统的表现提升了16.8%;在成本方面,相较于LambdaML,节省了28.3%的费用。

陈星耒个人介绍

- 本科毕业院校:上海交通大学

- 研究方向:Severless范式,分布式DNN训练

- 荣誉奖励:

- 2022-2023学年校二等奖学金

- 2023-2024学年校二等奖学金